Meta pubblica il codice nell'intelligenza artificiale ad accesso aperto sotto il nome ImmagineBind, che prevede relazioni tra dati simili a come le persone percepiscono o immaginano il loro ambiente. Mentre i generatori di immagini come Midjourney, Stable Diffusion e DALL-E 2 legano le parole alle immagini, consentendoti di creare scene visive basate solo su una descrizione testuale, ImageBind va oltre. Può collegare testo, immagini o video, audio, misurazioni 3D, dati di temperatura e dati di movimento, e lo fa senza la necessità di pre-addestramento in ogni occasione. Questa è una fase iniziale di un framework che alla fine sarà in grado di generare ambienti complessi da input semplici come un prompt di testo, un'immagine o un audio (o una combinazione di questi).

Puoi pensare a ImageBind come a un'approssimazione dell'apprendimento automatico all'apprendimento umano. Ad esempio, se ti trovi in un ambiente dinamico, come una strada trafficata della città, il tuo cervello (per lo più inconsciamente) assorbe immagini, suoni e altre sensazioni sensoriali per ottenere informazioni su auto in transito, edifici alti, il tempo e altro ancora . Gli esseri umani e altri animali si sono evoluti per elaborare questi dati per i nostri vantaggi genetici: sopravvivenza e trasmissione del nostro DNA. (Più conosci ciò che ti circonda, più puoi evitare i pericoli e adattarti al tuo ambiente per sopravvivere e prosperare meglio). Man mano che i computer si avvicinano all'imitazione delle connessioni multisensoriali degli animali, possono utilizzare tali connessioni per generare scene completamente realizzate basate solo su dati limitati.

Quindi, mentre potresti usare Midjourney per creare "un basset hound in un costume di Gandalf in equilibrio su un pallone da spiaggia" e ottenere una foto relativamente realistica di quella strana scena, uno strumento di intelligenza artificiale multimodale come ImageBind potrebbe finire per creare un video con il cane con rilevante suoni, tra cui un soggiorno dettagliato, la temperatura della stanza e la posizione esatta del cane e di tutti gli altri nella scena. "Questo crea un'eccellente opportunità per creare animazioni da immagini statiche combinandole con istruzioni audio", osservano i ricercatori di Meta nel loro blog orientato agli sviluppatori. "Ad esempio, un creatore può combinare un'immagine con una sveglia e un gallo che canta e utilizzare un segnale audio per segmentare il gallo o il suono della sveglia per segmentare l'orologio e animare entrambi in una sequenza video".

Per quanto riguarda cos'altro si può fare con questo nuovo giocattolo, indica chiaramente una delle ambizioni principali di Meta: VR, realtà mista e metaspazio. Ad esempio, immagina un visore futuro in grado di creare al volo scene 3D completamente realizzate (con suoni, movimento, ecc.). Oppure gli sviluppatori di giochi virtuali potrebbero alla fine usarlo per risparmiarsi una parte significativa del lavoro scrupoloso nel processo di progettazione. Allo stesso modo, i creatori di contenuti potrebbero creare video coinvolgenti con colonne sonore e movimenti realistici basati solo su testo, immagini o audio. È anche facile immaginare come uno strumento come ImageBind apra nuove porte all'accessibilità generando descrizioni multimediali in tempo reale per aiutare le persone con disabilità visive o uditive a comprendere meglio il loro ambiente.

Interessante anche: I migliori strumenti basati sull'intelligenza artificiale

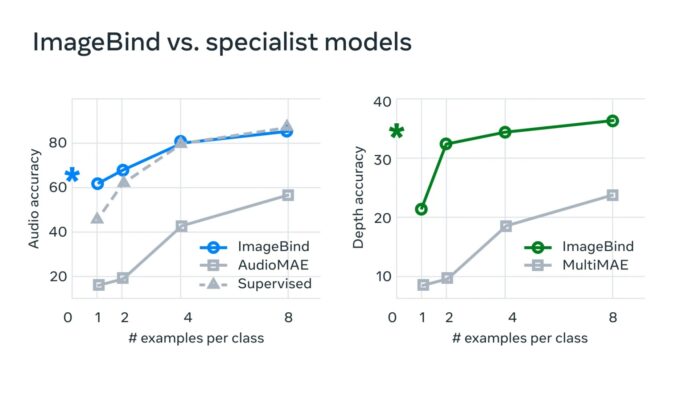

"Nei tipici sistemi di intelligenza artificiale, esiste un incorporamento specifico (ovvero vettori di numeri che possono rappresentare i dati e le loro relazioni nell'apprendimento automatico) per ciascuna modalità pertinente", afferma Meta. “ImageBind mostra che è possibile creare uno spazio di incorporamento comune per più modalità senza doversi addestrare sui dati con ogni singola combinazione di modalità. Questo è importante perché i ricercatori non possono creare set di dati con campioni che contengono, ad esempio, dati audio e dati termici da una strada trafficata della città, o dati di profondità e una descrizione testuale di una scogliera sul mare».

Meta ritiene che questa tecnologia finirà per andare oltre gli attuali sei "sensi", per così dire. "Sebbene abbiamo studiato sei modalità nel nostro studio attuale, riteniamo che l'introduzione di nuove modalità che colleghino il maggior numero possibile di sensi - come il tatto, la parola, l'olfatto e i segnali cerebrali fMRI - consentirà modelli di IA più ricchi incentrati sull'uomo". Gli sviluppatori interessati a esplorare questa nuova sandbox possono iniziare immergendosi nel codice open source di Meta.

Leggi anche: